ちょっとした「言い換え」でAIはだませる、MITが敵対的攻撃を実証

「テキストフーラー(TextFooler)」は、文中の特定の単語を同義語で置き換えるだけで自然言語処理(NLP)システムをだまして文章を誤解させることができるソフトウェアだ。同ソフトウェアを使った試験では、3つの最新のNLPシステムの正確度が大幅に低下した。たとえばグーグルのBERT(バート)の場合、イェルプ(Yelp)のレビューのネガポジ判定が5〜7倍も悪化した。

ニュースの内容判別やフェイクニュースの検出、感情の分析といったタスクの訓練済みのNLPシステムを攻撃すると、すべてのケースで人工知能(AI)は著しく成績を落とした。

マサチューセッツ工科大学(MIT)のチームが開発したこのソフトウェアは、NLP分類器にとって最も重要な単語を文中から探し出し、人間が自然と感じる同義語に置き換えるものだ。たとえば、「ありえないほど人為的な状況に配置された登場人物は、現実から完全に隔絶されている」という文を、「ありえないほど作り込まれた環境に配置された登場人物は、現実から十分に隔絶されている」に変えても、私たちが読むぶんには大して意味は違わない。だがこの加工で、AIによる文の解釈は完全に別のものになった。

このような敵対的攻撃の例はこれまで数多くあったが、多くは画像認識システムに関わるもので、入力画像に些細な改変を加えてAIを戸惑わせ、画像を誤分類させるものだった。テキストフーラーは、同様の敵対的攻撃によって、NLPも破られることを示すものだ。NLPは、シリ(Siri)やアレクサ(Alexa)、グーグル・ホームといったバーチャルアシスタント、スパムフィルターやヘイトスピーチ検出器のような言語分類器を裏で支えているAIだ。テキストフーラーのようなツールによってNLPの弱点をさらけ出すことで、より堅固なNLPシステムを作るのに役立つと研究チームは述べている。

オープンAIが「年齢予測」導入、子ども保護の責任誰が負う?

オープンAIが「年齢予測」導入、子ども保護の責任誰が負う?

MITの学生は「世界を変える10大技術」から何を学んでいるか?

MITの学生は「世界を変える10大技術」から何を学んでいるか?

eムック 『2026年に注目「気候テック企業」10社』特集号

eムック 『2026年に注目「気候テック企業」10社』特集号

期待外れのCRISPR治療、包括的承認で普及目指す新興企業

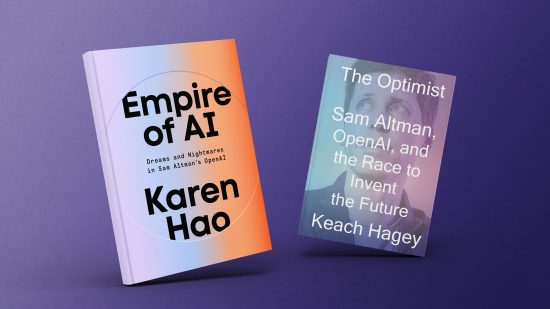

期待外れのCRISPR治療、包括的承認で普及目指す新興企業 書評:サム・アルトマンはいかにして「AI帝国」を築いたか

書評:サム・アルトマンはいかにして「AI帝国」を築いたか