大きいことはいいことだ!? LLMの「パラメーター」って何だ?

GPT-3は1750億、Gemini 3は推定7兆——LLMのパラメーター数は増大を続ける。AI企業が「大きさ」を競い合ってきたパラメーターとは一体何なのだろうか? そして、その役割とは? 噛み砕いて解説する。 by Will Douglas Heaven2026.01.13

- この記事の3つのポイント

-

- グーグル・ディープマインドの最新LLM「Gemini 3」は1兆個以上のパラメーターを持つと推定される

- LLMのパラメーターは埋め込み・重み・バイアスの3種類で構成され単語の意味と関係性を数値化する

- 小型モデルの性能向上には大量データ訓練や蒸留技術が鍵となり単純な規模拡大は限界に達している

きっかけは、ある夜中のメモ書きだった。編集部のひとりが目を覚まし、枕元のノートにこう走り書きしたのだ——「パラメーターって何?」と。午前4時に浮かんだ疑問としては、これがなかなかの名案で、大規模言語モデル(LLM)の核心に迫る問いでもある。ちなみにその編集者は私の上司だが、だからと言ってゴマをすっているわけではない。

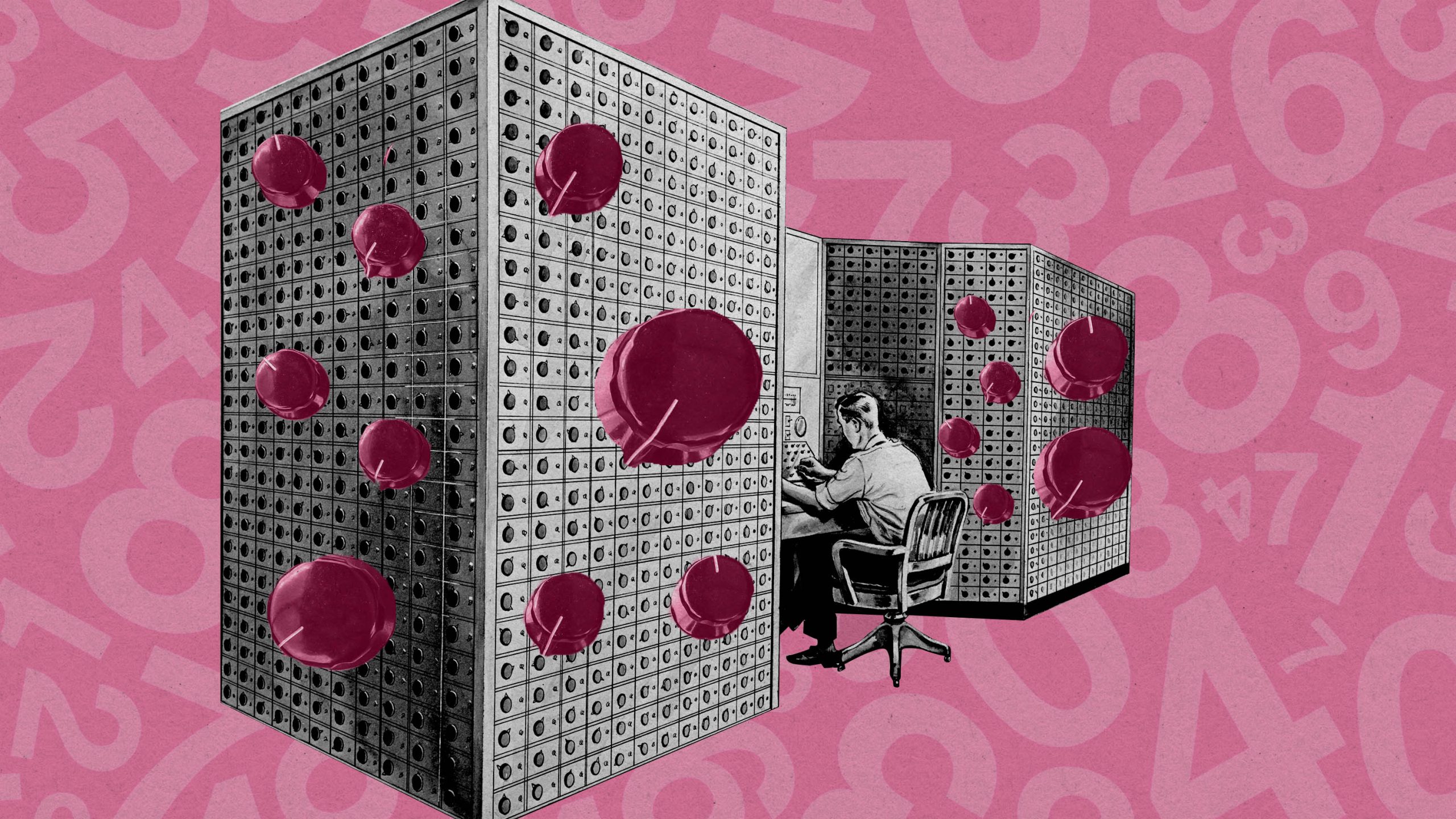

大規模言語モデルのパラメーターは、モデルの挙動を制御する「調整つまみ」や「レバー」のようなものだとよく言われる。たとえば、惑星サイズのピンボールマシンを想像してほしい。精密に設定された数十億のフリッパーとバンパーをボールが弾きながら、端から端まで移動する。その設定を少し変えるだけで、ボールの動きは大きく変化する。

オープンAI(OpenAI)が2020年に発表した「GPT-3」には、1750億個のパラメーターがあった。グーグル・ディープマインド(Google DeepMind)の最新のLLM「Gemini(ジェミニ) 3」には、少なくとも1兆個(中には7兆個と推定する見方もある)のパラメーターがあるとされるが、同社は具体的な数を明かしていない。AI企業間の競争が激化する中、モデルの構造に関する情報は非公開になりつつある。

とはいえ、パラメーターの基本的な役割と、それがどのようにしてLLMに驚くべき能力を与えるのかという仕組みは、どのモデルにも共通している。あのカラフルなピンボールマシンの比喩の背後に、どのような実体があるのか気になったことはないだろうか? この記事で詳しく見ていこう。

Q. パラメーターとは何か?

中学校で習った代数、たとえば「2a + b」を思い出してみてほしい。数式内のアルファベットはパラメーターであり、値を代入すると結果が得られる。数学やコーディングの世界では、パラメーターは出力や制限を決めるために使われる。LLMにおけるパラメーターも同様だが、その規模は桁違いに大きい。

Q. どのように値が割り当てられるのか?

簡単に言えば、アルゴリズムによって割り当てられる。モデルの訓練時、すべてのパラメーターには初期値としてランダムな数値が与えられる。その後、「訓練ステップ」と呼ばれる反復的な計算を通じて値が更新されていく。訓練初期のモデルは頻繁に間違いを犯し、アルゴリズムはその誤差をもとに、どのように値を調整すべきかを計算する。これを繰り返すことで、モデルは徐々に意図した通りの動作をするようになる。意図した通りの動作になった時点で訓練は停止し、パラメーターの値は固定される。

Q. 単純明快なプロセスのようだが……

理屈の上では単純だが、実際にはモデルが扱うデータ量とパラメーター数が膨大であるため、訓練には膨大な計算ステップと計算資源が必要になる。たとえばGPT-3のような中型モデルでも、1750億のパラメーターが何万回も更新される。その総計は1000兆回以上の計算に相当し、何千台もの専用高速コンピューターが数カ月間フル稼働するほどだ。

Q. すごい数。このパラメーターの目的は一体何?

LLMには、訓練を通じて値が割り当てられる3種類のパラメーターがある。それが「埋め込み(embedding)」「重み(weight)」「バイアス(bias)」である。それぞれを順に見ていこう。

Q. ではまず、「埋め込み」とは何?

「埋め込み」とは、LLMの語彙に含まれる単語(あるいは「トークン」と呼ばれる単語の一部)を数値で表現したものである。LLMの語彙は、訓練開始前に設計者によって定義され、数十万の固有トークンを含む場合もある。ただし、これらの単語にはあらかじめ意味が与えられているわけではない。その意味は、訓練によって学習される。

モデルの訓練中、語彙内の各単語には、膨大な訓練データにおける無数の出現例をもとに、他のすべての単語との関係性においてその意味を捉える数値が割り当てられる。

Q. つまり、単語は何らかの「コード」に置き換えられているということ?

そのとおりだ。ただし、それだけではない。各単語の埋め込みとは、1つの数値ではなく複数の数値のリストで構成されており、それぞれの数値が、モデルが訓練データから抽出した意味の異なる側面を表している。このリストの長さ(=次元数)は、LLMの設計者が訓練前に指定する。一般的なサイズとしては、4096がよく使われる。

Q. LLM内のすべての単語は、4096個の数値のリストで表されているということ?

そのとおり。それが「埋め込み(embedding)」であり、訓練中にこれら4096個の数値が調整されていく。したがって、4096次元の埋め込みを持つLLMは、「4096次元のモデル」と表現される。

Q. なぜ「4096」なのか?

直感的には奇妙な数値に見えるかもしれない。しかし、LLMは(コンピューター・チップ上で動作する他のあらゆるものと同様に)2の累乗、つまり2、4、8、16、32、64……といった数値で最も効率的に動作する。LLMの開発者たちは、4096が能力と効率のバランスにおいて最適な「スイートスポット」であると発見した。4096未満ではモデルの性能が下がり、4 …

- 人気の記事ランキング

-

- What’s next for Chinese open-source AI ディープシーク騒動から1年 中国のオープンモデルが 世界の開発者を席巻している

- Promotion Emerging Technology Nite #36 Special 【3/9開催】2026年版「新規事業の発想と作り方」開催のお知らせ

- EVs could be cheaper to own than gas cars in Africa by 2040 アフリカでEVがガソリン車より安くなる日——鍵は「太陽光オフグリッド」

- RFK Jr. follows a carnivore diet. That doesn’t mean you should. 「肉か発酵食品しか食べない」米保健長官が目指す「健康な米国」

- Why EVs are gaining ground in Africa アフリカ初のバッテリー工場も建設中、「次のEV市場」は立ち上がるか?