AIのエネルギー消費、

悲観しすぎなくていい

4つの理由

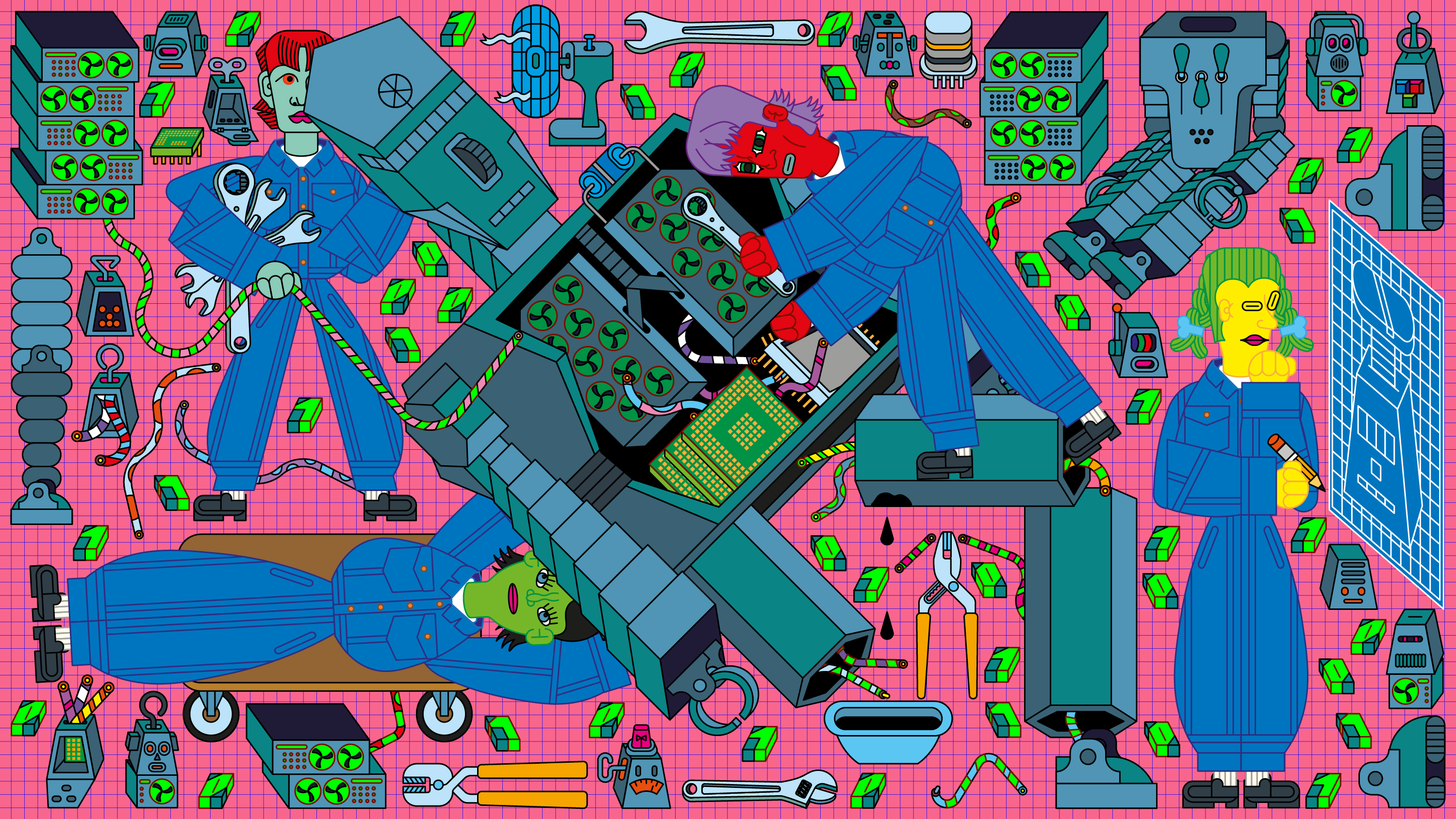

AIインフラの拡大でエネルギー消費への懸念が高まっているが、希望を抱かせる要素もある。モデルの効率化、半導体の進歩、データセンター冷却技術の向上、そしてコスト削減圧力が、持続可能性と経済性を両立させる方向へ業界を導いている。 by Will Douglas Heaven2025.05.30

- この記事の3つのポイント

-

- モデル小型化、新型チップ、冷却技術の革新で効率化が進んでいる

- 運用コストの大部分がエネルギー費用のため、企業は自然と省エネに取り組む

- 過去の技術革命と同様、普及とともに効率が向上するパターンが期待される

2025年1月の就任式の翌日、ドナルド・トランプ大統領は、人工知能(AI)インフラ構築を目的とした5000億ドル規模のプロジェクト「スターゲート」を発表した。プロジェクトには、複数の超大手テック企業が名を連ねている。米国全土における大規模データセンターと電力網の建設を加速し、中国に対する優位性を維持することを目指す。

世界的なAI覇権争いにおける「手段を選ばぬアプローチ」は、スイス・ダボスで開かれた世界経済フォーラム年次総会(通称ダボス会議)でも話題となった。こう話すのは、カナダの自動運転トラック開発スタートアップ、ワービ(Waabi)創業者兼CEOであるラケル・ウルタスンだ。ダボス会議は、トランプ大統領による発表と同じ週に開催された。「この業界の将来が非常に心配です」と、ウルタスンCEOは話す。

懸念を抱いているのは彼女だけではない。「資金が投じられ、GPUは焼付き、水は蒸発しています。まったくの逆方向に進んでいます」。シアトルを拠点とする非営利団体アレン人工知能研究所(Ai2)のアリ・ファルハディCEOは語る。

しかし、コストの高騰や気候への影響といった懸念に目を向けつつも、希望を抱かせる要素もある。AIモデルを支えるソフトウェア、そのソフトウェアを動かすチップ(半導体)、そしてそれらを24時間稼働させるデータセンターの効率を高めるイノベーションが進行中なのだ。

これら3つの領域すべてにおいて、エネルギー消費量、ひいては二酸化炭素排出量を削減できる方法について知っておくべきこと、そして慎重な楽観論を支持する根拠を以下に紹介する。根本的なビジネスの現実から、最終的にはよりエネルギー効率の高いAIへと向かうだろうと信じるに足る理由がそこにはある。

1. より効率的なモデル

最も明白な出発点は、モデルそのもの、すなわちその構築法と運用法である。

AIモデルは、大量のデータを使ってニューラルネットワークを訓練することで構築される。大規模言語モデル(LLM)は膨大なテキスト、自動運転モデルは膨大な走行データを用いて訓練される。

しかし、こうしたデータ収集の方法は、往々にして無差別である。大規模言語モデルは、インターネット全体から収集したテキストや、大規模な書籍スキャンデータなどのデータセットで訓練される。あらゆるものを手当たり次第にかき集めて混ぜ合わせ、何が出てくるかを見てみる――そんな方法が一般的だった。確かに成果は出ているが、膨大なデータセットを用いてモデルを繰り返し訓練し、関連パターンをモデル自身に見つけさせるというのは、時間とエネルギーの浪費でもある。

もっと効率的な方法があるかもしれない。子どもが、すべての書物を読むことで学ぶとは誰も思っていない。代わりに、彼らには集中したカリキュラムが与えられる。ウルタスンCEOは、AIにもそれと同様のアプローチが必要だと考えている。つまり、特定のタスクに特化した、より厳選されたデータでモデルを訓練するやり方だ(ワービは、モデルに提示するバーチャル・データを細かく制御できる超高精度のシミュレーション環境でロボット・トラックの訓練を実施している)。

これは、ワービに限ったことではない。サンフランシスコに拠点を置き、企業顧客向けに大規模言語モデルを構築しているAI関連スタートアップ企業のライター(Writer)は、合成データを用いることで、モデルの訓練と運用にかかる費用を抑えているという。大規模だが無選別なデータセットではなく、特注のデータセットをモデルに与えることで、訓練時間を短縮する(つまり、コストも削減できる)。たとえば、ライターのチームは、ウィキペディアを単純にダウンロードするのではなく、ウィキペディアの個々のページを取り出し、その内容をテキストブロックではなく、Q&A形式などさまざまな形式に書き換えることで、少ない情報からより多くのことをモデルが学習できるようにしている。

訓練はモデルのライフサイクルの始まりに過ぎない。モデルが大きくなるにつれて、運用コストも高くなっている。クエリを段階的に処理し、最終的な応答を生成する、いわゆる「推論(reasoning)」モデルは、一つの応答に対してそれぞれ中間応答を計算するため、特に電力を大量に消費する。このような新機能のコストは目が飛び出るほど高額で、オープンAI(OpenAI)の「o3」推論モデルは、1つのタスクの実行に最大3万ドルかかると見積もられている。

ただし、この技術は登場してからまだ数カ月しか経っておらず、依然として実験段階にある。AI2のファルハディCEOは、こうしたコストはやがて低下すると見ている。たとえば、エンジニアたちは、推論モデルが実行不可能な道筋をたどる前に、それを途中で止める方法を見つけ出すだろう。「新しいことを最初にやるときは、莫大な費用がかかるものです。しかし、その後で、より小型かつ効率的にする方法が見つかります」とファルハディCEOは語る。「テクノロジーの世界では、それが一貫した傾向なのです」。

エネルギー消費を大幅に増やすことなく性能を向上させる方法の一つは、モデルが応答を生成する際に実行する計算(推論ステップ)を並列で処理する手法だとファルハディCEOは説明する。並列計算は、現代のソフトウェア、特に大規模言語モデルの基盤となっており、GPUも並列処理を前提に設計されている。それでもなお、この基本的手法はより広範な問題に適用可能である。タスクを分割し、それぞれを同時に処理することで、並列計算はより高速に結果を得られ、同時にハードウェアの使用効率を高めることで電力消費を抑えることもできる。ただし、複数のサブタスクを連携させ、最終的に1つの結果に統合するために …

- 人気の記事ランキング

-

- What’s next for Chinese open-source AI ディープシーク騒動から1年 中国のオープンモデルが 世界の開発者を席巻している

- Promotion Emerging Technology Nite #36 Special 【3/9開催】2026年版「新規事業の発想と作り方」開催のお知らせ

- EVs could be cheaper to own than gas cars in Africa by 2040 アフリカでEVがガソリン車より安くなる日——鍵は「太陽光オフグリッド」

- RFK Jr. follows a carnivore diet. That doesn’t mean you should. 「肉か発酵食品しか食べない」米保健長官が目指す「健康な米国」

- Why EVs are gaining ground in Africa アフリカ初のバッテリー工場も建設中、「次のEV市場」は立ち上がるか?