「わかりやすい説明」とは何か? グーグル・ブレインらが研究

説明可能な人工知能(AI)とは、人間にとって理解しやすい意思決定を目指すシステムである。賞賛に値する目標だが、何をもって「良い説明」とするのだろうか?

それを知るたった1つの方法は、ユーザーに尋ねることだ。ハーバード大学とグーグル・ブレイン(Google Brain)の研究者が実施した一連の研究がこれにあたる。被験者は、エイリアンの食習慣や健康状態を学習するように設計された機械学習アルゴリズムに関する、入力/出力/説明の異なる組み合わせを検討した(そう、被験者自身の偏見を避けるために、エイリアンの生活を選んだのだ)。その後、ユーザーはそれらのさまざまな組み合わせをスコア化した。

研究で分かったことは、長い説明は短い説明よりも解釈するのがより難しいということだ。長い説明を多くの短い文に分割した方が、長い説明を読ませるよりもユーザーには理解しやすいことが分かった。すでに気づいているとおり、この試験では情報伝達方法のかなり基本的な要素を検討したことになる。研究はまだ始まったばかりだ。

オープンAIが「年齢予測」導入、子ども保護の責任誰が負う?

オープンAIが「年齢予測」導入、子ども保護の責任誰が負う?

MITの学生は「世界を変える10大技術」から何を学んでいるか?

MITの学生は「世界を変える10大技術」から何を学んでいるか?

eムック 『2026年に注目「気候テック企業」10社』特集号

eムック 『2026年に注目「気候テック企業」10社』特集号

期待外れのCRISPR治療、包括的承認で普及目指す新興企業

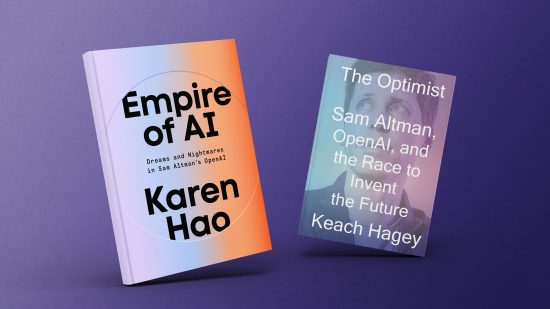

期待外れのCRISPR治療、包括的承認で普及目指す新興企業 書評:サム・アルトマンはいかにして「AI帝国」を築いたか

書評:サム・アルトマンはいかにして「AI帝国」を築いたか