フェイスブックの有害コンテンツ対策、ロンドン警視庁の映像も活用

フェイスブックのコンテンツ監視は現在、その大部分が自社開発の機械学習システムで自動的に実行されており、人間のモデレーターが審査しなければならない悲惨なコンテンツの量を減らしているという。11月に発表された最新のコミュニティ規定実施報告書(Community Standards Enforcement Report)でフェイスブックは、テロに関連する動画や写真の98%は、誰の目にも触れることなく、もちろん通報される前に削除したと主張した。

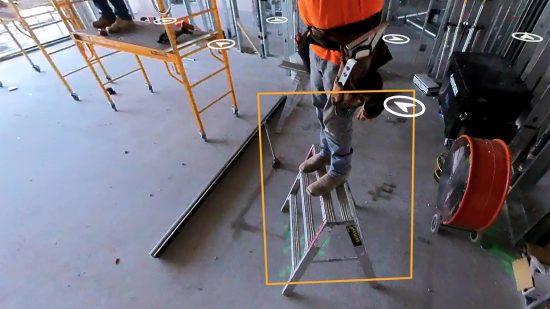

フェイスブックは動画中の物体を識別しラベル付けをするために、独自の機械学習システムを訓練してきた。動画中の物体とは、日常的なもの(たとえば花瓶や人間)から危険性のあるもの(たとえば銃やナイフ)までさまざまだ。フェイスブックの人工知能(AI)は危険なコンテンツを探すのに、主に2つの手法を用いている。1つは既知の物体の特徴や挙動を検知し、信頼度を含めてラベル付けするニューラルネットワークの活用だ(冒頭の動画参照)。

ニューラルネットワークは、人間の審査によってあらかじめラベル付けされた動画とユーザーからの通報の組み合わせなどによって訓練されており、近々、ロンドン警視庁が撮影した動画が加わる予定だ。ニューラルネットワークはロンドン警視庁の動画を使って、あるシーン全体の状況を推測し、フラグを立てる必要がある行動や画像が含まれているかどうかを判断できる。フェイスブックは11月末の記者発表で、このシステムについてさらに詳細を発表した。

もしシステムが、ある動画ファイルに問題のある物体や挙動が含まれていると判断した場合、ハッシュ値(固有の数字文字列)が作成される。ハッシュ値によって問題のある動画を示しシステム全体にその情報を伝達、照合し、一致するコンテンツがネットワーク内から自動的に取り除かれる。このハッシュ値は他のソーシャルメディア企業とも共有できるので、他社が有害ファイルのコピーを削除することも可能だ。

「ロンドン警視庁の映像は、大変役に立っています。幸いなことに、テロはめったに起こりません。つまり、訓練データ量が非常に少ないということです」。フェイスブックのエンジニアリング・マネージャー、ニコラ・ボルティグノンは電話でこう語った。

フェイスブックは現在も、言語の意味やニュアンス、コンテキストの理解の自動化に苦労している最中だ。そのため今なお、規約に違反するいじめや嫌がらせに関する投稿の圧倒的多数を、人間からの通報に依存している。システムが識別する規約違反の投稿はわずか16%なのが現状だ。テクノロジーが進化するにつれ、その数字も向上していくと期待できる。だが、AIに言語を真に理解させるという目標は、業界最大の難問の1つであり続ける。

今年3月には、ニュージーランドのクライストチャーチにある2つのモスクで49人が殺害されるテロ事件が起きた。犯人は大量殺人の様子をフェイスブックでライブ配信しており、その動画は事件後、数カ月に渡ってフェイスブック上で拡散された。この事態が業界にとって契機となった。仮にこうした事態がいま起きれば、より迅速に発見され、削除される可能性が高いだろう。

「クラウド」を超えて——次世代データセンターは宇宙を目指す

「クラウド」を超えて——次世代データセンターは宇宙を目指す

米国務省、外国デマ監視部門を廃止 「言論の自由」理由に

米国務省、外国デマ監視部門を廃止 「言論の自由」理由に

eムック 「戦争とテクノロジー 変わる戦場の風景」特集号

eムック 「戦争とテクノロジー 変わる戦場の風景」特集号

米FDA、新型コロナワクチンを高齢者らに限定 その合理性は?

米FDA、新型コロナワクチンを高齢者らに限定 その合理性は?

書評:サム・アルトマンはいかにして「AI帝国」を築いたか

書評:サム・アルトマンはいかにして「AI帝国」を築いたか