脱GPUへアナログ回路、

機械学習の省エネ化に挑む

AIモデルの訓練に求められる計算能力が増加し、GPUが消費するエネルギー量もうなぎ上りだ。ペンシルベニア大学のチームは、従来とは異なるアプローチでエネルギー効率の高い機械学習デバイスを構築する取り組みを進めている。 by Sophia Chen2024.06.10

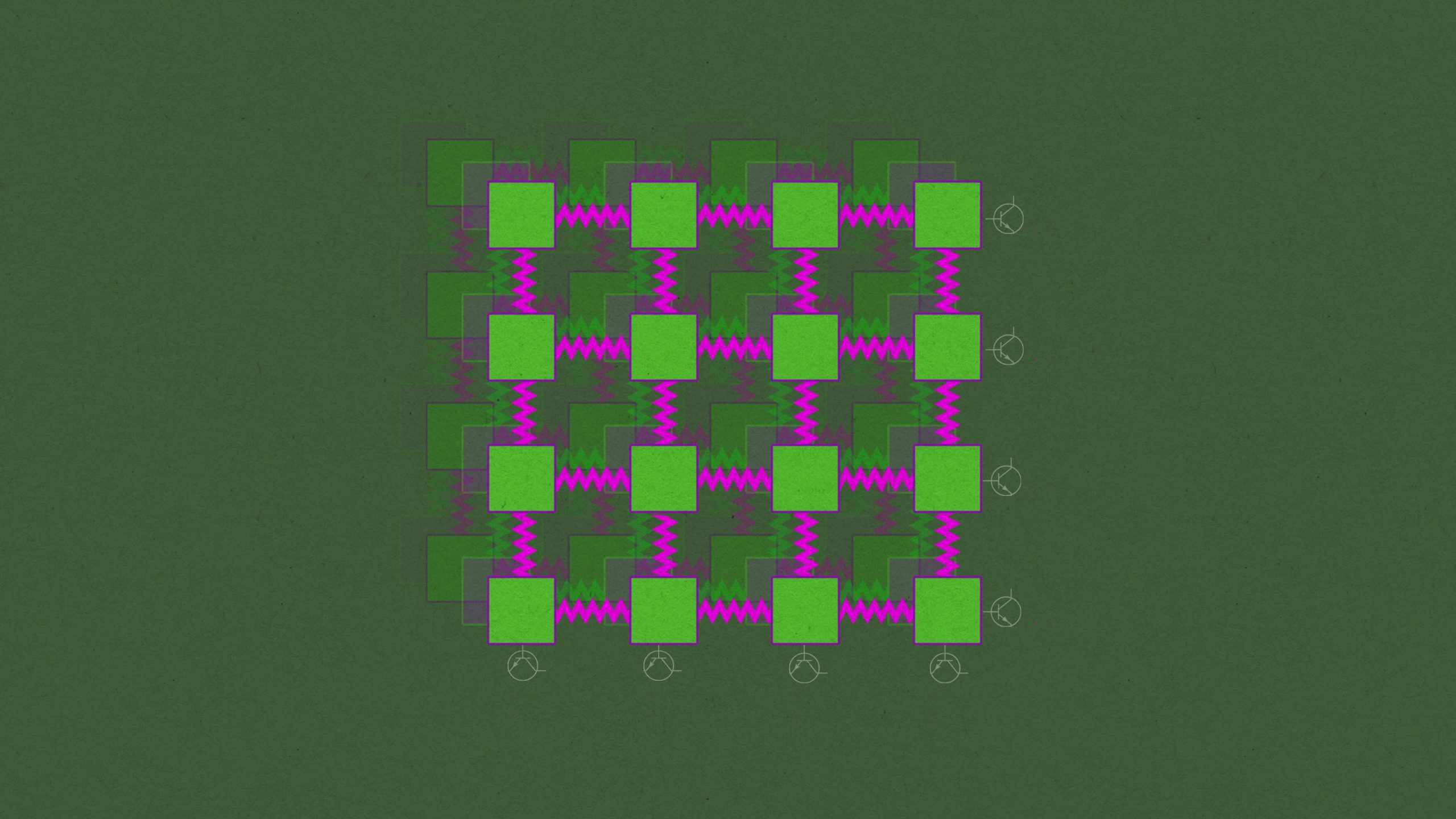

ペンシルベニア大学の研究室にあるテーブルの上で、物理学者のサム・ディラヴー博士は、色鮮やかなケーブルを網のように張り巡らせて、多数のブレッドボード(部品やリード線をボードの穴に差し込むだけで、 はんだ付けをしなくても電子回路を組み立てられる基板)を接続した。装置の見た目は手作り(DIY)家電プロジェクトの作品さながらで、これといってエレガントではない。しかし、32個の可変抵抗器を組み込んだこの地味な装置は、機械学習モデルのようにデータの並べ替えを学習することができる。

現在の機能は初歩的なものだ。しかし、このプロトタイプは、機械学習で広く使われるエネルギー消費の激しいGPU(画像処理装置)チップに代わる省エネチップになることが期待されている。

「各抵抗器はシンプルなもので、それ単体では無意味といえるようなものです」とディラヴー博士は言う。「しかしそれらをネットワークに組み込めば、さまざまなタスクをこなすように訓練できるのです」。

この回路が実行するのは、花弁の長さや幅などの特性によって花を分類するタスクである。花に関するこうした測定値を入力すると、回路はそれらを3種類のアヤメに分類することができた。この種の作業は「線形」分類問題として知られる。なぜならアヤメの情報をグラフに起こすと、直線を使ってデータを正しいカテゴリーにきれいに分類できるからだ。タスク実行にあたって研究者たちは花の測定値を電圧として表し、それを回路に入力した。そして回路は3種類の花のうちいずれかに対応する出力電圧を生成した。

これはGPUのアプローチとは根本的に異なるデータの符号化方法である。GPUは情報を2進数の1と0で表現する。ディラヴー博士の回路では、情報は最大または最小の電圧、あるいはその間の電圧で表される。この回路は120本のアヤメを95%の正確度で分類した。

研究チームは今回、この回路にさらに複雑な問題を解かせることに成功した。現在査読中の論文(プレプリント)の中で、同チームは、この回路がXOR(排他的論理和)として知られる論理演算を実行できることを示した。この回路は2進数の数字2つを受け取り、入力値が同じかどうかを判断したのだ。これは 「非線形 」分類タスクであり、「非線形性こそ、あらゆる機械学習の真髄です 」とディラヴー博士は言う。

彼らが実演したことは、人々が毎日使っているデバイスにとっては朝飯前のタスクだ。しかしそこは問題ではない。 ディラヴー博士らのチームは、より優れたコンピューターの設計を探求する取り組みとしてこの回路を作ったのだ。コンピューター業界は、これまで以上にパワフルな機器を提供しようと骨折っている中で、存続の危機に直面している。2012年から2018年の間に、最先端の人工知能(AI)モデルに求められる計算能力は30万倍の増加をみた。現在、1つの大規模言語モデル(LLM)の学習に使われるエネルギー量は、米国の住宅100軒分以上が1年間に消費するエネルギー量に並ぶ。ディラヴー博士は、自分の設計が、より高速なAIを構築するための、エネルギー効率の高い代替アプローチとなることを期待している。

二人三脚の学習

この回路がさまざまなタスクを正しく実行するためには、訓練が必要である。従来のコンピューターチップ上で動作する現代の機械学習モデルと同じだ。たとえばチャットGPT(ChatGPT)は …

- 人気の記事ランキング

-

- It’s pretty easy to get DeepSeek to talk dirty 「お堅い」Claude、性的会話に応じやすいAIモデルは?

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- Google’s new AI will help researchers understand how our genes work グーグルが「アルファゲノム」、遺伝子変異の影響を包括的に予測

- Tech billionaires are making a risky bet with humanity’s future マスク、アルトマン、ベゾス ——テックセレブたちが描く 未来への「危険な賭け」

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法