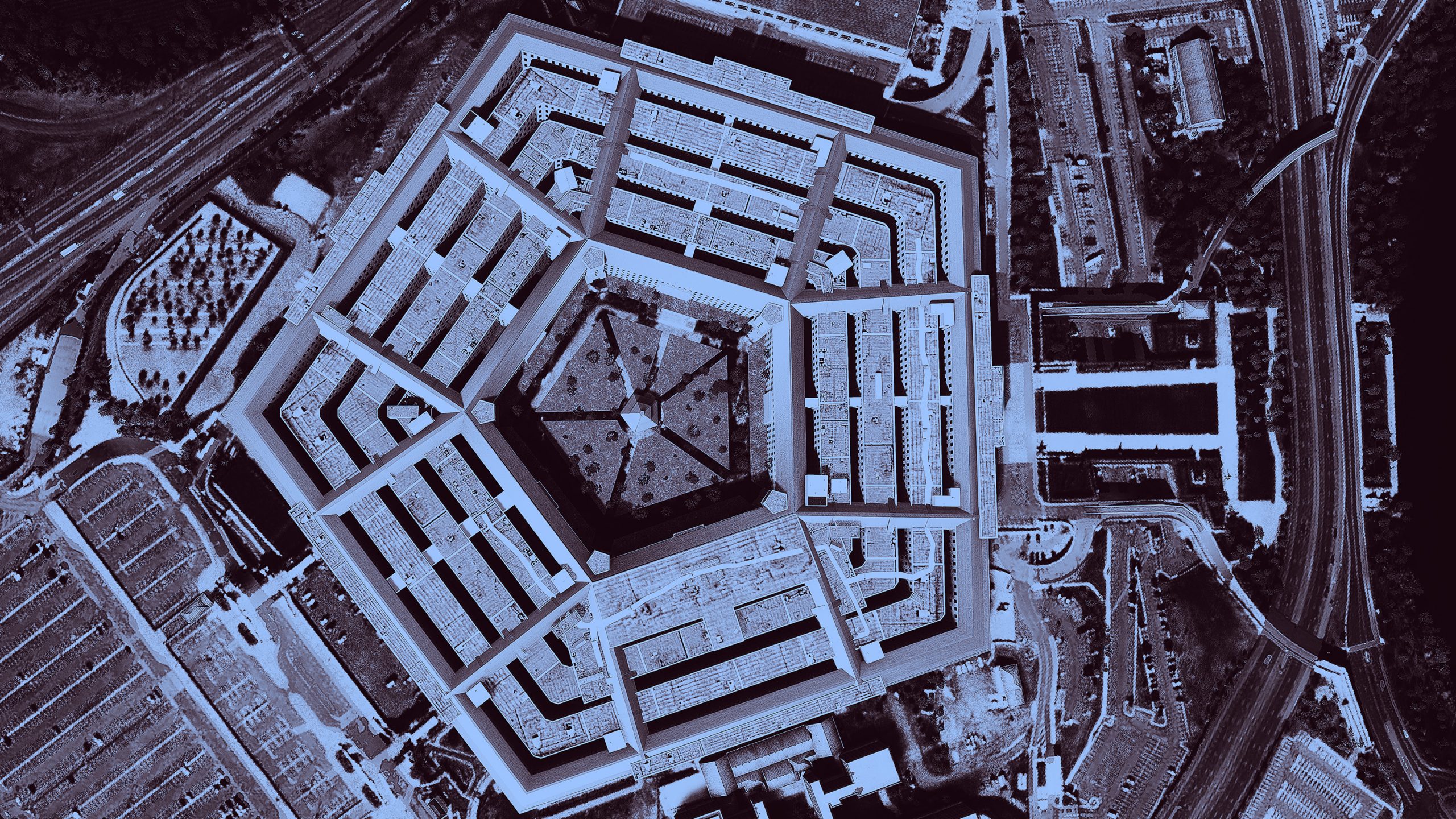

米国防総省がAI倫理ガイドラインを発表、開発・運用手順を規定

米国防総省が「責任あるAIの指針」を発表した。AIの軍事利用が批判を浴びる中、政府請負業者へ倫理原則の遵守を求め、透明性の向上を図ることが狙いだ。 by Will Douglas Heaven2021.11.24

2018年にグーグルの従業員は、同社が米軍のプロジェクト・メイブン(Project Maven)に関わったと知り、心穏やかではなかった。プロジェクト・メイブンは、監視ビデオを分析する人工知能(AI)を開発しようという米軍の試みであり、さまざまな議論を巻き起こしたプロジェクトだ。グーグル社内では、同プロジェクトに関わったことに数千人が抗議し、「グーグルは戦争ビジネスに関わるべきではないと私たちは思う」と経営幹部宛てに書簡を出した。そして、十数人の従業員が自らグーグルを退職した。結局グーグルは、2019年には契約更新を思いとどまった。

プロジェクト・メイブンは今なお存在する。グーグルが契約更新を止めた後は、アマゾンやマイクロソフトといった他のテック企業が取って代わったのだ。それでも、米国防総省は、自身が信用問題を抱えていることを知っている。AIなどの最新テクノロジーを活用するには、巨大テック企業や他の非軍事的組織との協力が必要だ。最新テクノロジーを活用し続けるために、国防総省は信頼確保に取り組まなければならない。

民間企業と国防総省との契約を取り仕切る「国防イノベーション部隊(Defense Innovation Unit)」は、透明性の向上を目指す「責任あるAIの指針」を発表した。人事管理システムであろうと標的認識であろうと、軍事用のAIを構築する際に第三者の開発者が従うべき指針をまとめたものだ。

このガイドラインは、民間企業がシステムを計画、開発、運用をする際に従うべき、段階的なプロセスを規定している。ガイドラインにはテクノロジーを誰が使用するか、テクノロジーで誰が損害を受けるか、どんな損害が想定できるか、どうすれば損害が避けられるかを確認する手順などが入っている。しかも、システムを構築する前だけでなく、立ち上げて運用を始めてからも従うべき手順となっている。

「率直に言って国防総省に限らず、米国政府内にこれほど詳細に踏み込んだガイドラインはほかにありません」。ガイドラインを共同執筆した、国防イノベーション部隊のブライス・グッドマンは述べる。

国防総省のガイドラインを他の省が採用、あるいは他の省に適合させれば、米国政府によるAI開発の方法が変わるかもしれない。グッドマンは、同僚と共にガイドラインを米国海洋大気庁や米国運輸省に提供し、司法省、共通役務庁、内国歳入庁の倫理グループとも協議していると言う。

ガイドラインの目的は、請負業者が国防総省のAIに関する現行の倫理原則に確実に従うようにすることだと、グッドマンは説明する。国防総省は、国防イノベーション委員会(Defense Innovation Board)に委任した2年間の調査を経て、昨年、これらの倫理原則を発表した。国防イノベーション委員会は、シリコンバレーの活気を米軍にもたらすために、優れたテクノロジー研究者やビジネス関係者を集めて2016年に設立された諮問委員会だ。委員会の議長はグーグルの元CEOであるエリック・シュミットが2020年9月まで務め、現在はマサチューセッツ工科大学(MIT)コンピュータ科学・人工知能研究所のダニエラ・ルス所長などがメンバーとなっている。

しかし、この調査がどのような意味のある改革を約束するのか、疑問を持つ声もある。

調査の間、委員会は、軍のAI使用を声高に批判する人々を含め、幅広い専門家に助言を求めた。例えば、殺人ロボット反対キャンペーンのメンバーや、元グーグルの研究者で、プロジェクト・メイブンへの抗議運動の組織化を手助けしたニューヨーク大学のメレディス・ウィテカー教授らだ。

ニューヨーク大学AIナウ研究所(AI Now Institute)の共同設立者でもあるウィテカー教授から、本記事へのコメントは得られなかった。同研究所のコートニー・ホルスワース広報責任者によれば、ウィッタカー教授は会議に一度出席し、シュミット議長など委員会の上席メンバーと調査の方向性について議論した。だが、「ウィッタカー教授は決して有意義な相談を受けたわけではありません」と言う。「長いプロセスのほんの一部で異議を唱える声が上がっても、『結果は利害関係者から幅広い賛同を得ている』という主張に利用されるのであれば、一種の倫理洗浄になりかねません」。

国防総省が幅広い賛同を得ていなくても、ガイドラインは信頼を築く助けとなるのだろうか。「国防総省が作り出すどんな倫理ガイドラインに対しても、考え方が矛盾していると言い、決して満足しない人が出てくるでしょう」と、グッドマンは述べる。「ガイドラインには何ができて、何ができないのかを、現実的に考えることが重要です」。

例えば、活動家が禁止すべきだと訴えているテクノロジーである、殺人につながる自律兵器の使用について、ガイドラインには何も述べられていない。しかし、殺人テクノロジーを管理する規制は、組織系統の上層部によって決定されるとグッドマンは説明する。ガイドラインの目的は、規制を満たすAIをより構築しやすくすることだ。そのために、第三者の開発者が抱くどんな不安もはっきり示すというのも、そのプロセスの一部だ。「このガイドラインの有効な活用方法は、特定のシステムについて追究しないと決めることです」と、ガイドラインの共著者である国防イノベーション部隊のジャレッド・ダンモンは話す。「その考えは良くないと判断できます」。

ティムニット・ゲブルと共にグーグルの倫理AIチームを率い、のちに解雇された、ハギング・フェイス(Hugging Face)のAI研究者であるマーガレット・ミッチェルは、プロジェクトに携わる者にとって倫理ガイドラインは、プロジェクトを、少なくとも理論上は、より透明性のあるものにする助けになると主張する。ミッチェルは、グーグル社内での抗議運動を最前列で見ていた。従業員たちの主な批判の1つは、グーグルが何の予防策も用意せずに、強力なテクノロジーを軍に譲り渡したというものだったとミッチェルは言う。「特に、何らかのはっきりしたガイドライン、あるいは透明性が欠如しているため、一部の従業員は会社を去ることになりました」。

ミッチェルはそれほど明確ではない。「グーグルには、きっぱりと、軍の仕事はすべて悪いと感じている人もいると思います」とミッチェルは言う。「私はそういう人たちとは違います」。ミッチェルは、企業の倫理原則を支持する方向で企業といかに連携できるかを国防総省に伝えてきた。

ミッチェルは、国防総省が現在求めている信頼を得るのは、もう少し先だろうと考える。問題の一つは、ガイドラインの表現の中に何通りにも解釈できるものがあることだ。例えば、「国防総省はAIに発生する意図しないバイアスを最小限にするため、慎重な手段を取る」と述べられている。「意図しないバイアス」とは何を指すのだろうか。重箱の隅をつつくように思われるかもしれないが、解釈の違いはこのような細かなことに左右される。

軍事テクノロジーの使用の監視は、一般的にセキュリティ・クリアランス(機密情報へアクセスするための信用資格)が必要なため難しい。これに対処するために、国防総省との請負契約では、クリアランスを持つ外部監査人を設け、ガイドラインが確かに守られていることを確認することで、企業を安心させることができるとミッチェルは言う。「従業員は、ガイドラインが期待通りに解釈されているという保証を求めているのです」。

- 人気の記事ランキング

-

- Namibia wants to build the world’s first hydrogen economy 砂漠の国・ナミビア、 世界初「水素立国」への夢

- Promotion MITTR Emerging Technology Nite #33 バイブコーディングって何だ? 7/30イベント開催のお知らせ

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- What comes next for AI copyright lawsuits? AI著作権訴訟でメタとアンソロピックが初勝利、今後の展開は?

- Why the US and Europe could lose the race for fusion energy 核融合でも中国が優位に、西側に残された3つの勝機

- Google’s electricity demand is skyrocketing グーグルの電力使用量が4年で倍増、核融合電力も調達へ

- ウィル・ダグラス・ヘブン [Will Douglas Heaven]米国版 AI担当上級編集者

- AI担当上級編集者として、新研究や新トレンド、その背後にいる人々を取材しています。前職では、テクノロジーと政治に関するBBCのWebサイト「フューチャー・ナウ(Future Now)」の創刊編集長、ニュー・サイエンティスト(New Scientist)誌のテクノロジー統括編集長を務めていました。インペリアル・カレッジ・ロンドンでコンピュータサイエンスの博士号を取得しており、ロボット制御についての知識があります。