戦争とAI

曖昧化する責任の境界線

人工知能(AI)が戦場で人間の意思決定を支援することが一般的になりつつある。だが、問題が起こったときに責任を負うべきは誰なのだろうか。その境界線は曖昧になりつつある。 by Arthur Holland Michel2023.09.19

近未来の戦争を思い浮かべてほしい。その戦争はもしかしたら、明日にでも始まるかもしれない。

ある兵士が誰もいない建物の屋上に敵を狙撃するための陣地を構えている。兵士の所属する部隊は街中のあらゆる区画で戦闘をしている。どの曲がり角にも敵が静かに待ち伏せており、チャンスさえあればこちらに銃撃を浴びせる準備ができているかもしれないと、兵士たちには思えてくる。

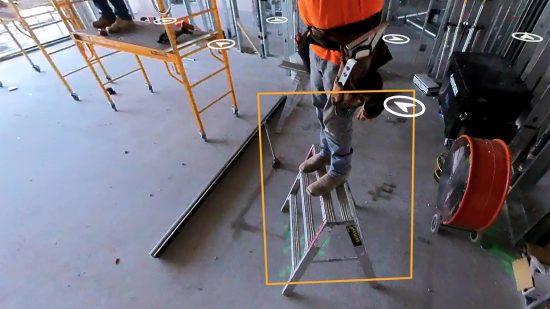

照準器越しに近くにある建物の窓を観察する兵士は、ベランダに洗ったばかりの洗濯物がぶら下がっているのに気づく。無線で連絡が入る。兵士の部隊が建物の下の開けた場所を間もなく通過するとのことだ。部隊が動き始めると、兵士の照準器の左上に赤いバウンディングボックス(物体や人物を指し示す四角い枠)が表示される。照準器のコンピュータービジョンシステムが、敵兵士の可能性がある人物がいると警告しているのだ。窓越しに見える人影が構えを取り、銃撃しようとしているように見える。

兵士は、その人影をはっきりとは視認できない。しかし、コンピュータービジョンはどんなわずかな敵の気配でも検知する人間を超えた能力を持っていると、兵士は自らの経験から学んでいる。そこで兵士は照準をバウンディングボックスに合わせ、引き金を引く準備をする。

別の戦争を思い浮かべてほしい。この戦争も近い将来に起こるかもしれないものだ。ある司令官がたくさんのモニターの前に立っている。チャットボットが警告を発している。チャットボットによれば、敵のロケット発射場として用いられる可能性がある街の区画に、1台のトラックが侵入したことを人工衛星が検知したという。チャットボットはすでに、砲兵隊にそのトラックに狙いを定めさせ、待機をさせておくべきだというアドバイスを出している。チャットボットの計算によれば、砲兵隊を用いることで「致命確率」が最大化されるのだという。

チャットボットは、付近の建物はいずれも市民のものではないという。ただし、そう断定するには人間による確認も必要になると、注意もしている。現地を詳しく確認するためにシステムが派遣していたドローンが、現場に到着する。ドローンからの映像には、トラックがバック走行で2つの敷地の間にある狭い路地へと入っていく場面が映されている。トラックを砲撃するチャンスは急速に閉ざされようとしている。

司令官にはもう、周囲の音は聞こえていない。戦場の混沌も、不確実性も、騒音もすべて、司令官は忘れている。代わりに司令官はただ、迫りくるタイムリミットのことを考えながら、目の前で光を放つボタンを眺めている。

「砲撃命令を承認する」

引き金を引くという決断、場合によっては、引かないという決断。ボタンを押すという決断、あるいは押さないという決断。法的にも、そして倫理的にも、生死にまつわる兵士の決断が担う役割は、極めて重要で、避けられないものだ。根本的に、人間による戦争を定義するのは、こうした生死にまつわる決断なのだ。

そう考えると、世界各国および市民社会が人工知能(AI)を用いた自律兵器(人間による指示を一切必要とせずに標的を選択および攻撃できる兵器)の問題に関して大きな懸念を持つようになったことは当然だろう。2023年5月、国連の「特定通常兵器使用禁止制限条約(Convention on Certain Conventional Weapons)」締約国は、10年間に及んだ議論を終えた。各国は、戦争法を遵守するため、軍隊が自律兵器を用いる際には、「期間、地理的範囲、作戦規模を制限」する必要があるとの勧告で合意した。この勧告に法的拘束力はないが、少なくとも殺戮に繋がる一瞬の過程のどこか、ある時点において、人間が関与する必要があるという認識を示したものだ。

人間の意思決定を完全に代替するAI自律兵器は、まだ(おそらくは)実際に使用されているわけではない。米国など大国が配備している「自律型」ドローンや船舶ですら、人間によって注意深く監視されながら使用されている。一方で、ただ引き金を引くのをガイドするだけのインテリジェント・システムはすでに、好戦的な国々の間で兵器の一部として浸透し始めている。軍用のインテリジェント・システムは知らぬ間に大きく発展を遂げ、新たな問いを投げかけている。その問いは、殺人ロボットなどという古臭い議題よりも答えを出すのが難しく、日に日により喫緊のものとなっている。その問いとは、次の通りだ。決断が部分的には人間に、部分的には機械によってなされるということはどういうことなのだろうか? 人間と機械が誰かを殺戮するという決断を共に下すとき、その決断が倫理的なものとなり得ることは果たしてあるのだろうか?

長きにわたり、コンピューターを用いて人間の決断を支援するというアイデアは、ここまで物議を醸すとは思われていなかった。退役した米国空軍の中将であるジャック・シャナハンは、自らが1980年代に操縦していたF4ファントム戦闘機に搭載されたレーダーもある種の決断支援ツールであったと述べている。レーダーは他の航空機の存在をパイロットに警告で伝えてくれたので、自らはどのように対処できるかを考えることができたと、シャナハンは言う。しかし、パイロットとレーダーが対等の立場にある共犯者だと言ってしまうのは、誇張というものだろう。

人間と機械の関係は一変し始めている。「少なくとも私の見解では、現在は人間と機械がある種のチームとして作戦を遂行せねばならなくなってきているのです」と、シャナハンは言う。

特に機械学習の登場により、軍が重要な決断を形成する際のコンピューターの活用法は大きく変化を遂げた。そして、コンピューターが戦争における究極の決定にまで関与する可能性すら出てきている。シャナハンは「プロジェクト・メイブン(Project Maven)」の最初のプロジェクト長だった。プロジェクト・メイブンとは、ペンタゴン(米国防総省)による主導のもと、ドローンの映像内で標的を認識するアルゴリズムを開発したプログラムである。プロジェクト・メイブンは米国によるAIの軍事利用の新時代の到来を告げるものだった。「深層学習のアルゴリズムはほぼ人間と同じレベルの能力を発揮できる」という研究結果が発表された2017年に、プロジェクトは始まった(一方、プロジェクト・メイブンは物議を醸すことにもなった。2018年、3000人以上のグーグル従業員が、プロジェクト・メイブンにグーグルが関与していることに抗議する文書に署名した)。

機械学習をベースにした意思決定ツールは、従来のツールよりも「明らかに高い能力を持ち、使い道も多様です」と、マット・トゥレックは言う。トゥレックは米国国防先端研究計画局(DARPA)の情報イノベーション室で副室長を務めている。「結果として、おそらく以前よりも、人間の意思決定における機械の役割が大きくなる傾向にあります」。

たとえば、敵の狙撃手を警戒する兵士は、「アサルト・ライフル戦闘応用システム(Assault Rifle Combat Application System)」を用いながら警戒に当たるかもしれない。このシステムとは、イスラエルの防衛企業、エルビット・システムス(Elbit Systems)が販売する照準器のことだ。エルビット・システムの仕様書によれば、「AIを活用した」同照準器は550メートル以上の距離でも「人間のターゲットを検知」し、サッカーのフィールドほどの距離でも人間のターゲットを「識別」できるという(推察するに、そのターゲットが撃ってもよい人物かどうかを見極めるということだろう)。エルビット・システムスの広報責任者であるアンナ・アーロンハイム・コーエンは、MITテクノロジーレビューの取材で次のように述べている。「この照準器システムは、歩兵たちが参加した演習で実際に使用され、テスト済みです」。

スマートシューター(Smartshooter)という企業が開発した別の照準器も、同様の能力を持つと宣伝されている。スマートシューターのWebサイトによれば、同社の照準器は遠隔操作のマシンガンにも搭載できるという。2021年にイスラエルのエージェントがイラン人原子力科学者であるモハセン・ファクリザデを暗殺する際に用いたのも、遠隔操作マシンガンの一種だった。

戦場から遠く離れた場所で使用する決断支援ツールも、上述した照準器と同じぐらい、人間の決断に影響力を及ぼし得る。情報を分析し、場合によっては敵への攻撃を決定することもある一連のプロセスは「キルチェーン(kill chain)」と呼ばれるが、ペンタゴンはキルチェーンにおいてAIを使用したことがあると見られている。ただし、ペンタゴンは詳細についてはっきりと明かしていない。MITテクノロジーレビューからの質問に対して、米空軍の広報責任者であるローラ・マクアンドリュースは、空軍では「人間と機械をチームとして扱うアプローチを利用しています」と回答する。

他の国の軍は、人間の判断を機械にある程度委ねる試みを、よりオープンにしている。2021年に起こったイスラエルとパレスチナとの紛争のすぐ後で、イスラエル国防軍は差し迫った攻撃について部隊へと警告したり、作戦のターゲットを提案したりするために、AIツールと同軍が呼称するものを紛争中に使用したと述べた。

ウクライナ軍は「GISアルタ(GIS Arta)」と呼ばれるプログラムを使用している。このプログラムはアルゴリズムに基づき、戦場でロシア軍の各ターゲットを特定し、そのターゲットを攻撃するのに最適な場所にいる砲兵隊を教えてくれる。 英タイムズ(Times)紙の記事には、GISアルタはウーバーの運転手と乗客を結びつけるアルゴリズムと似ていると記されている。このアルゴリズムによって、ターゲットの発見から攻撃までの時間が大幅に短縮されるのだという。ウクライナ軍がGISアルタの使用を開始する前は、発見から攻撃までに20分を費やしていたが、現在は1分しかかからないという。

ロシアもAIを搭載した独自の指揮・統制システムを保有していると主張している。だが、そのシステムの技術的詳細については、ほとんど明らかにしていない。ワドワーニAI・先進テクノロジー研究センター(Wadhwani Center for AI and Advanced Technologies)のグレゴリー・アレン所長は、AIの軍事利用に関する各国の主張の一部は鵜呑みにしないことが重要だと話す。アレン所長はペンタゴンの現在のAIに関する方針の立案にも携わっている人物である。ロシアの軍用AIとされるテクノロジーの中には、「数十年前から存在する、いたってありふれたものもあり」、GISアルタも「単なる従来型のソフトウェア」だと述べている。

軍事的な意思決定をするにあたっては、さまざまな判断が必要となる。ただし、判 …

- 人気の記事ランキング

-

- It’s pretty easy to get DeepSeek to talk dirty 「お堅い」Claude、性的会話に応じやすいAIモデルは?

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- Google’s new AI will help researchers understand how our genes work グーグルが「アルファゲノム」、遺伝子変異の影響を包括的に予測

- Namibia wants to build the world’s first hydrogen economy 砂漠の国・ナミビア、 世界初「水素立国」への夢

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法