深層学習で解決されていない最大の欠陥の1つに、いわゆる敵対的攻撃(adversarial attack)に対する脆弱性がある。人間の目には無作為に見えたり、気付かなかったりする攪乱要素を人工知能(AI)システムの入力データに加えると、完全に機能不全にさせることができるというものだ。例えば、「止まれ」の標識にある意図を持ってステッカーを貼ると、時速45マイル(約72キロメートル)の標識を見ているように自動運転車を勘違いさせられる。道路上にステッカーを貼れば、テスラ(Tesla)の自動運転車を混乱させて対向車線に誘導することも可能だ。

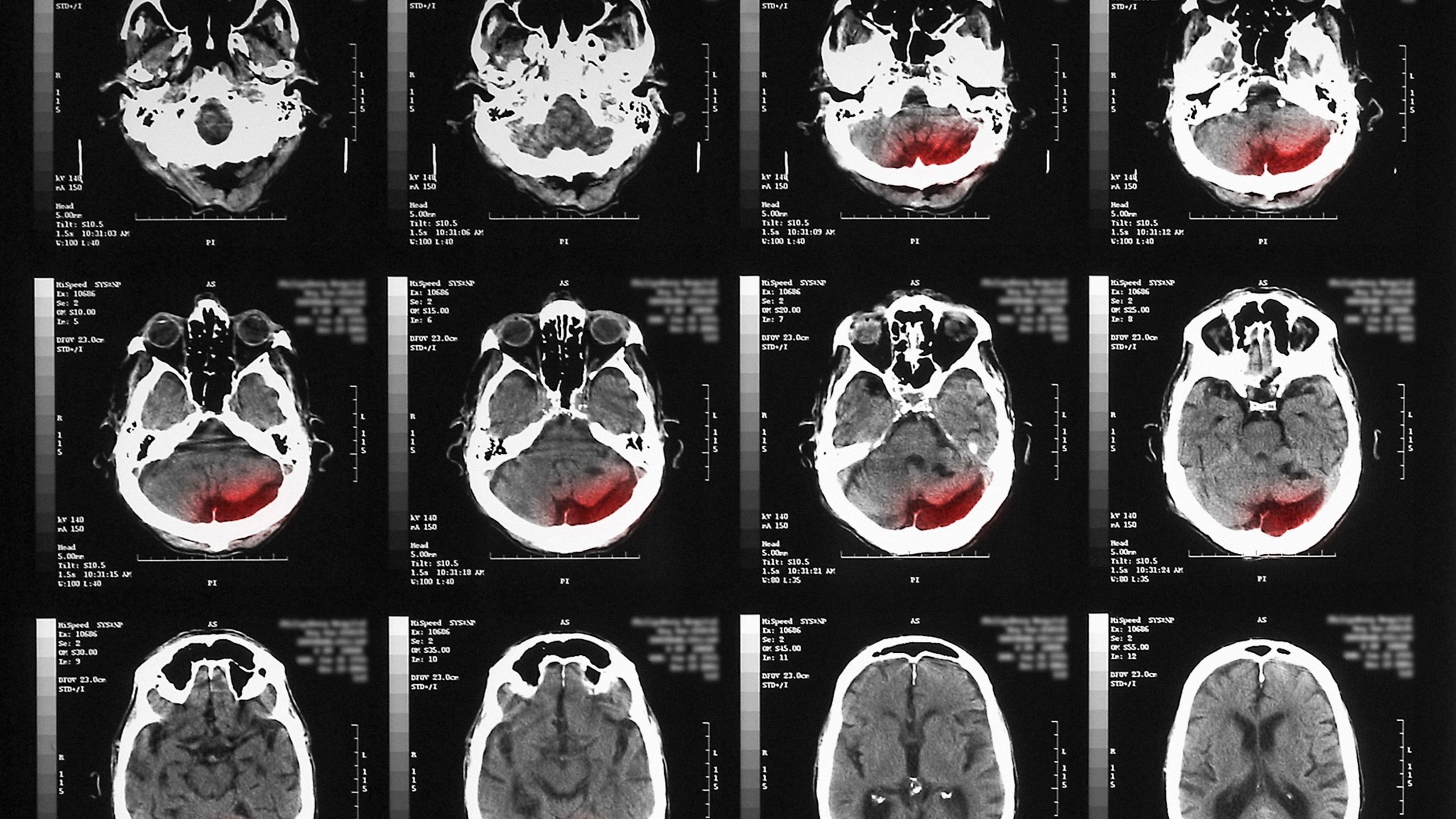

敵対的攻撃に関する研究の大部分では画像認識システムに焦点が当てられているが、深層学習をベースとする画像再構築システムにも同じような脆弱性がある。X線データやCTスキャン、MRIスキャンなどの医療用画像を再構築するのに、画像再構築システムを利用することの多い医療分野では特に問題となる。標的を絞った敵対的攻撃により、そうしたシステムが、実際には腫瘍のない箇所に腫瘍があるかのようにスキャン画像を再構築してしまう可能性があるのだ。

イリノイ大学アーバナ・シャンペーン校のボー・リー 教授(2020年のMITテクノロジーレビューの「35歳未満のイノベーター」に選出された1人)と同僚らが、安全を重視すべきシナリオにおいて、深層学習システムのミスを予防し、信頼性を向上させるような新たな訓練法を提案している。それは、画像再構築を担うニューラル・ネットワークを、敵対的サンプル生成する別のニューラル・ネットワークと対峙させるというもので、敵対的生成ネットワーク(GAN)アルゴリズムと似た手法だ。敵対的なネットワークは、再構築ネットワークをだまそうと、元になるデータ、すなわち「グラウンドトゥルース」の一部ではないものを繰り返し生成する。これに対し、再構築ネットワークは自己を微調整し続けてだまされるのを防ぎ、現実世界でも安全に展開できるようにする。

研究チームが、この手法で訓練したニューラル・ネットワークを2つの有名な画像データセットで検証してみると、別の方法で「ミスを犯しにくく」された他のニューラル・ネットワークよりも、グラウンドトゥルースをうまく再構築できた。しかしながらこの結果は完璧なものではなく、さらなる改良を要することも示された。この研究は、7月14日から始まる「機械学習に関する国際会議(ICML)」で発表される。

- 人気の記事ランキング

-

- It’s pretty easy to get DeepSeek to talk dirty 「お堅い」Claude、性的会話に応じやすいAIモデルは?

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- Google’s new AI will help researchers understand how our genes work グーグルが「アルファゲノム」、遺伝子変異の影響を包括的に予測

- Tech billionaires are making a risky bet with humanity’s future マスク、アルトマン、ベゾス ——テックセレブたちが描く 未来への「危険な賭け」

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- カーレン・ハオ [Karen Hao]米国版 寄稿者

- 受賞歴のあるフリー・ジャーナリスト。人工知能が社会に与える影響について取材している。ウォール・ストリート・ジャーナル紙の海外特派員として中国のテクノロジー業界を担当。2022年4月まではMITテクノロジーレビューのAI担当上級編集者を務めた。