典型的な自然言語処理モデルの訓練には膨大な計算パワーが必要であり、大量の二酸化炭素を排出する。その量は、米国製セダン車が耐用年数内に放出する炭素量のほぼ5倍に相当する。画像認識モデルの訓練で消費されるエネルギーは、一般的な住宅で消費されるエネルギーの2週間分だ。大手テック企業は1日に複数回、こうしたモデルの訓練を実施している。

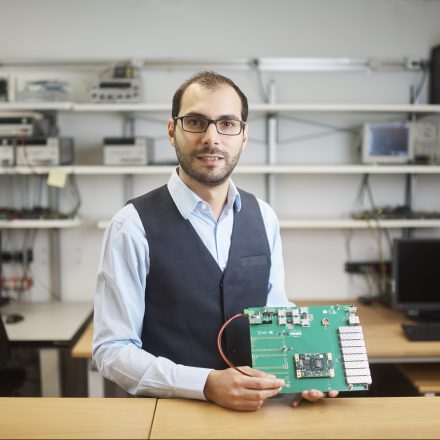

現代のコンピューティングではメモリとプロセッサーの間でデータを絶えず転送する必要があり、エネルギーの多くはそのために使用されている。マニュエル・ル・ガロはIBMの研究チームと協力して、より高速でエネルギー効率が高く、しかも高精度な、新しい種類のコンピューティング・アーキテクチャを実現するためのテクノロジーを開発している。

ル・ガロの研究チームは、メモリ自体を使用してデータを処理するシステムを開発した。これまでの研究ですでに、精度と大幅なエネルギー節約の両方を実現できることが示されている。研究チームは最近、従来の方法で実行した場合のわずか1%のエネルギーで処理を完了した。

金融分野から生命科学に至るまでの企業が人工知能(AI)モデルを改善するため絶えず訓練を実施しており、今後もエネルギー需要は急増するだろう。「私たちの手法により、二酸化炭素排出量と、モデルの訓練に費やされるエネルギーは確実に削減され、モデルの高速化とエネルギー効率向上が可能になります」とル・ガロは言う。

- 人気の記事ランキング

-

- It’s pretty easy to get DeepSeek to talk dirty 「お堅い」Claude、性的会話に応じやすいAIモデルは?

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- Google’s new AI will help researchers understand how our genes work グーグルが「アルファゲノム」、遺伝子変異の影響を包括的に予測

- Calorie restriction can help animals live longer. What about humans? 「若返り薬」より効果? カロリー制限のメリット・デメリット

- When AIs bargain, a less advanced agent could cost you 大規模モデルはやっぱり強かった——AIエージェント、交渉結果に差

| タグ | |

|---|---|

| クレジット | Samuel Trümpy |

| 著者 | MIT Technology Review編集部 [MIT Technology Review Editors] |